Chief Identity Officer (CIdO). Voilà le nouveau terme introduit par le Gartner pour définir le poste de responsable des identités au sein d’une organisation. Si ce terme est encore récent, les défis à venir concernant l’identité numérique pourraient bien propulser le CIdO au même rang que ses homologues CISO et CIO (respectivement Chief Information Security Office et Chief Information Officer), si bien que le Gartner estime que d’ici à 2027, 45% des responsables IAM en entreprises seront promus à des niveaux de cadre dirigeant [1]. Les défis sont nombreux (intégration de l’IAM au sein d’une stratégie Zero Trust, développement exponentiel des identités machines, modes de travail hybrides, etc.), et une expertise IAM sera nécessaire pour y répondre.

Fort de son expérience sur le sujet de l’identité numérique, Wavestone publie en 2024 sa première édition du radar du CIdO. Ce radar suit la même méthodologie que le radar du RSSI publié depuis 10 ans par le cabinet, et propose un zoom sur les tendances de fond qui animent l’écosystème de l’identité numérique.

Nous vous proposons dans cet article de (re)découvrir quelques sujets impactants et structurants pour le paysage IAM (Identity and Access Management) en en partant de deux sujets ayant le vent en poupe actuellement (passwordless et CLM) pour ensuite se diriger vers les sujets futurs qu’ils laissent entrevoir, dans la partie émergent du radar (predictive anti-fraud et cryptographie post-quantique).

Le passwordless, une évolution majeure pas si simple à organiser

Le mot de passe a été durant des décennies le facteur d’authentification central en informatique (et il l’est encore souvent). Le mot de passe a ensuite été intégré à des stratégies d’authentification multifacteur dans le but de compenser les faiblesses inhérentes à ce mode d’authentification (faible complexité, réutilisation, risque de phishing, etc.). De nouveaux outils sont ainsi venus s’ajouter à la cinématique d’authentification de l’utilisateur : OTP SMS ou mail, notification push, soft token et hard token entre autres. Malgré l’élévation du niveau de sécurité permise par l’ajout de ces nouveaux facteurs d’authentification, le mot de passe reste à la fois un point de faiblesse s’il est découvert (il reste réutilisable sur un compte sans MFA où il est enrôlé) et un poids pour l’expérience de l’utilisateur qui doit s’en souvenir et le stocker de manière sécurisée.

Toutes ces raisons ont poussé les éditeurs à imaginer des modes d’authentification sécurisés ne reposant pas sur l’utilisation d’un mot de passe. L’élimination du mot de passe permet aux entreprises d’améliorer l’expérience utilisateurs de leurs collaborateurs, d’élever le niveau de sécurité des authentifications en réduisant la surface d’attaque et de bénéficier d’une image positive sur le marché. L’utilisateur se retrouve alors dans un environnement où il n’a plus besoin de se rappeler d’une multitude de mots de passe complexes, et où il ne risque plus de se faire voler son compte par phishing. L’utilisation de la technologie FIDO2 (Fast Identity Online 2) reposant sur la cryptographie asymétrique est aujourd’hui l’alternative au mot de passe la plus répandue. Cette technologie poussée par la FIDO Alliance (Google, Microsoft, Amazon, Apple, etc.) repose sur l’utilisation de clés de sécurité physiques stockant localement la clé privée associée à chaque service et permettant à un utilisateur de se connecter à l’ensemble de ses comptes sans mot de passe, et même sans utiliser de login ou d’adresse mail (en utilisant simplement la clé physique en sa possession et un deuxième facteur tel que la biométrie).

La mise en place du passwordless s’accompagne cependant d’importantes questions organisationnelles pour une structure. Comment gérer la récupération d’un compte si celui-ci ne repose pas sur un mot de passe ? Si un collaborateur perd sa clé de sécurité, comment faire pour lui redonner accès à son compte sans pouvoir utiliser la clé privée associée ? Ce sujet majeur du « credentials recovery » est indissociable de toute politique passwordless et suppose qu’une organisation ait anticipé chaque étape de celle-ci : achat et distribution des supports d’authentification, gestion de leur perte/vol/oubli/destruction, processus de rotation des supports obsolètes, solution de back-up des comptes, double enrôlement pour les comptes critiques, gestion des départs de collaborateurs, etc.

Le passwordless est un sujet en vogue et est en cours de déploiement dans de nombreuses organisations. Pour beaucoup, l’étape suivante passe par l’établissement de capacités de détection des fraudes avant qu’elles ne soient commises (aussi appelé « predictive anti-fraud »).

Predictive anti-fraud, comment empêcher une fraude avant qu’elle ne soit commise ?

Le « Predictive anti-fraud » correspond une surveillance proactive des systèmes dans le but d’identifier et de stopper une fraude avant même qu’elle ne soit réalisée, et non plus de se limiter à une analyse à postériori des actes malveillants. Ces capacités de surveillance trouvent en particulier leur sens pour sécuriser les activités commerciales en ligne impliquant des transferts d’argent (cagnotte, compte fidélité, paiement en ligne, etc.) dans les secteurs de la grande distribution, du luxe ou du retail par exemple (car souvent moins matures sur ce sujet que les banques). Nous assistons d’ailleurs actuellement à une hausse des attaques de phishing visant à voler des données de comptes client afin d’en détourner de le contenu (les fraudes à la carte de fidélité sont par exemple un vrai sujet pour les acteurs de la grande distribution).

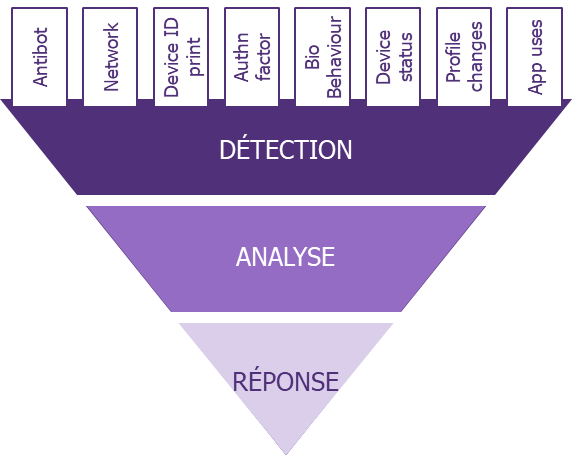

Les solutions de gestion d’accès sont aujourd’hui de plus en plus capables de détecter des patterns de fraude et de stopper des activités illicites avant leur finalisation. Toutes ces capacités reposent sur du machine learning (impliquant une phase d’entrainement des outils) et passent par trois étapes :

- La détection: les systèmes sont capables de détecter des comportements s’éloignant des parcours utilisateurs/clients courants ainsi que des successions d’actions suspectes. La détection s’appuie à la fois sur le contexte statique du client (navigateur utilisé, réseau, cookie, etc.), le contexte dynamique (adresse IP, appareil utilisé, comportement utilisateur, vitesse de frappe, force de l’authentification réalisée, etc.) et sur le contexte métier en question (type de transaction demandée, montants, modifications d’informations sensibles, etc.).

- L’analyse: une analyse automatique est conduite avec l’attribution d’un score de confiance accordé au profil en cours d’utilisation.

- La réponse: des règles de réponse sont définies afin de répondre au mieux aux levées d’alerte, avec des réponses automatiques pour les situations évidentes ou critiques (ex : facteur d’authentification supplémentaire, coupure de la session), ou des réponses manuelles pour les cas nécessitant une prise de décision humaine.

Le principal défi du predictive anti-fraud est le bon calibrage des outils de machine learning, et leur bonne adaptation au contexte métier en question. Un accent trop fort sur la sécurité pourrait avoir un impact trop négatif sur le service : nombre important de faux positifs affectant l’expérience utilisateur, alourdissement et ralentissement du service (captcha, step-up authentication, consommation réseau importante, temps de traitement rallongés). La définition de règles de sécurité et de détections pertinentes doit être accompagnés d’un machine learning le plus personnalisé et complet possible. Face à la croissante complexité des attaques, la clé d’une stratégie de predictive anti-fraud efficace réside dans la capacité des solutions à détecter et corréler des signaux faibles. Par exemple, certains éditeurs sont aujourd’hui capables de détecter des tentatives de fraude au conseiller, en corrélant les actions réalisées par un utilisateurs et le fait qu’il soit ou non en communication téléphonique.

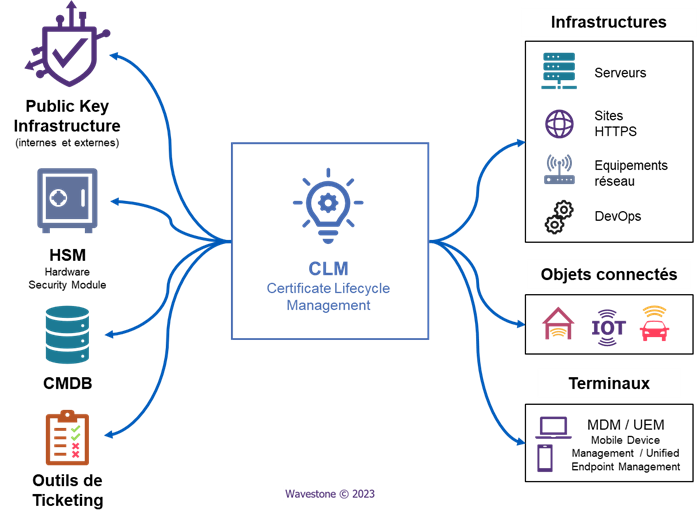

Certificate Lifecycle Management (CLM), un nouveau marché pour un problème ancien

De nombreuses entreprises sont actuellement confrontées à une explosion du nombre de certificats électroniques au sein de leur SI. Ces certificats (et les clés cryptographiques associées) ont de nombreuses utilités comme l’authentification machine-to-machine, l’authentification des utilisateurs, la signature et le chiffrement de données, la sécurisation des sites web, des micro-services applicatifs et des communications entre objets connectées, etc. Cette augmentation du nombre de certificats électroniques sous gestion accroît considérablement la charge des équipes.

Le cycle de vie d’un certificat électronique comprend de nombreuses étapes comme :

- La demande du certificat auprès d’une PKI (Public Key Infrastructure)

- La réception du certificat et des clés associées

- Le déploiement du certificat sur son périmètre (soit en remplacement d’un ancien certificat expirant bientôt, soit sur un nouveau périmètre)

- Le décommissionnement et la révocation de l’ancien certificat remplacé (le cas échéant)

- Le suivi continu du certificat et de sa future date d’expiration

- Reproduction de ce processus pour chaque certificat avant son expiration

Une gestion manuelle de dizaines (voire de centaines) de milliers de certificats électroniques pose de nombreux problèmes. Ce type de gestion est très demandeur en ressources humaines, repose sur des tâches répétitives tout en étant propice aux erreurs humaines. Il n’est en effet pas rare que des certificats passent sous le radar des équipes et ne soient pas renouvelés, ou qu’ils ne soient tout simplement pas déclarés au sein du SI (shadow IT). Pour toute ces raisons, une organisation disposant d’une large flotte de certificats électroniques devrait envisager de recourir à une solution de CLM.

Les solutions de CLM proposent de nombreuses fonctionnalités permettant de faciliter et fiabiliser la gestion du cycle de vie des certificats. Parmi ces fonctionnalités on retrouve, par exemple :

- Des outils de découverte de certificats permettant à une entreprise d’avoir une vision exhaustive de sa flotte de certificats (même pour les certificats non déclarés)

- L’utilisation de protocoles automatisant toutes les actions autour des certificats mentionnées ci-dessus

- De nombreux connecteurs permettant à leurs clients d’intégrer au mieux ces solutions au sein de leur SI

- Des modules de gouvernance et de gestion des droits sur les certificats

- Des capacités d’alerting représentant un filet de sécurité pour les équipes

La philosophie « Zero Trust », nécessitant souvent de sécuriser les communications entre services par authentification mutuelle à l’aide de certificats électroniques (avec le recours de plus en plus fréquent aux architectures en micro-services, à l’explosion du nombre de comptes non humains, etc.) tend à accroître le nombre de certificats électroniques au sein des organisations. Utiliser des outils de gestion dédiés à la gestion du cycle de vie des certificats plutôt qu’un suivi manuel permet de réduire de 90% les incidents liés aux certificats, et de réduire de 50% le temps de traitement de ces incidents, selon le Gartner[2].

Pour plus de détail sur les solutions de CLM, vous pouvez lire l’article de Wavestone consacré à ce sujet ici.

L’implémentation d’une solution de CLM est synonyme d’un pas en avant vers la sécurisation des infrastructures, mais aussi et surtout vers la crypto-agilité (capacité à rapidement remplacer ou mettre à jour des algorithmes ou des protocoles de chiffrement pour faire face à l’évolution des menaces). La crypto-agilité est un thème qu’il faut s’attendre à retrouver de plus en plus souvent à moyen terme, en grande partie à cause du développement des ordinateurs quantiques.

Et après ? Des défis technologiques à venir, exemple de la cryptographie post-quantique

Alors que les organisations s’efforcent d’adopter des stratégies IAM robustes, la prise en compte des menaces technologiques actuelles n’est désormais plus suffisante. L’avènement prochain des ordinateurs quantiques (les CIdO ont tout de même encore quelques années devant eux) sera amené à bouleverser toutes nos habitudes de chiffrement, ce qui nécessite d’anticiper le plus tôt possible les mesures à appliquer pour la décennie 2030. Le recours aux ordinateurs quantiques et à leurs fameux qubits (pouvant à la fois prendre 0 ou 1 comme valeur) permet dès aujourd’hui de tester des calculs cryptographiques beaucoup plus efficacement qu’avec l’utilisation d’ordinateurs traditionnels.

Il est important de noter que la cryptographie symétrique n’est pas à risque face aux menaces quantiques, et qu’augmenter la taille des clés de chiffrement permettra à ce mode de chiffrement d’y résister assez efficacement. Cependant, la cryptographie asymétrique utilisée pour sécuriser un canal d’échange de clés, avant l’utilisation de la cryptographie symétrique est réellement mise en danger par les ordinateurs quantiques. L’algorithme de Shor pourrait permettre à un ordinateur quantique de casser un chiffrement basé sur du RSA 2048 en quelques heures. La cryptographie-post quantique s’intéresse donc actuellement aux solutions permettant d’adapter le chiffrement aux capacités futures des ordinateurs quantiques. Le NIST a ainsi publié en 2022 une liste de 4 algorithmes de chiffrement résistants aux ordinateurs quantiques : CRYSTALS-Kyber pour le chiffrement général, CRYSTALS-Dilithium, FALCON et SPHINCS+ pour la signature électronique.

La principale recommandation actuelle permettant d’assurer la transition vers un chiffrement post-quantique est d’effectuer un chiffrement hybride, c’est-à-dire d’utiliser à la fois des algorithmes de chiffrement classiques et post-quantiques afin de sécuriser les communications. Si cette problématique n’est pas encore au cœur des enjeux IAM actuels, il convient d’en suivre l’évolution, d’autant plus que certains grands éditeurs commencent déjà à investir le marché et à introduire un nouveau terme : QCaaS (Quantum Computing as a Service).