Le 13 mars 2024, le Parlement a adopté définitivement la version finale du Règlement Européen Artificial Intelligence Act, aussi dit « AI Act »[1]. Près de trois ans après la publication de la première version du texte, les vingt-sept pays de l’Union Européenne sont parvenus à un accord historique sur les premières règles harmonisées à l’échelle mondiale en matière d’intelligence artificielle. La version finale du texte est attendue pour le 22 avril 2024, avant publication au Journal Officiel de l’Union Européenne.

L’AI Act vise à garantir que les systèmes et modèles d’intelligence artificielle commercialisés au sein de l’Union européenne soient utilisés de manière éthique, sûre et respectueuse des droits fondamentaux de l’UE. Cette loi a également été rédigée pour renforcer la compétitivité et l’innovation des entreprises en matière d’IA. L’AI Act réduira les risques de dérives, renforçant la confiance des utilisateurs dans son utilisation et adoption.

France Digitale, la plus grande association de startups en Europe, Gide, un cabinet d’avocats d’affaires français à dimension internationale, et Wavestone, ont réuni leurs forces pour co-écrire un livre blanc pour vous permettre de comprendre et appliquer la loi européenne sur l’IA : L’AI Act : les clés pour comprendre et appliquer la loi européenne sur l’intelligence artificielle.

Dans cette publication, France Digitale, Gide et Wavestone vous partagent leur vision de l’AI Act, des types de systèmes concernés aux grandes étapes de la mise en conformité.

Quelques définitions pour commencer

L’AI Act effectue une distinction entre les systèmes et les modèles d’intelligence artificielle qu’il définit comme suit :

- Un système d’intelligence artificielle (SIA) est un système automatisé conçu pour fonctionner à différents niveaux d’autonomie et qui peut générer des prédictions, des recommandations ou des décisions qui influencent les environnements physiques ou virtuels.

- Un modèle d’intelligence artificielle à usage général (“General Purpose AI systems” ou “GPAI”) est un système d’IA polyvalent, capable d’exécuter un large éventail de tâches distinctes. Il peut être intégré dans une variété de systèmes ou d’applications, démontrant ainsi une grande flexibilité et adaptabilité.

Acteurs concernés

L’AI Act concerne tous les fournisseurs, distributeurs ou déployeurs de systèmes et de modèles d’IA, personnes morales (entreprises, fondations, associations, laboratoires de recherche, etc.), dont le siège social se situe dans l’Union européenne, ou lorsque le siège social est situé en dehors de l’Union européenne, qui commercialisent leur système ou modèle d’IA dans l’Union européenne.

Le niveau de réglementation et les obligations associées dépendent du niveau de risque que présente le système ou le modèle d’IA.

La classification des SIA selon le niveau de risque

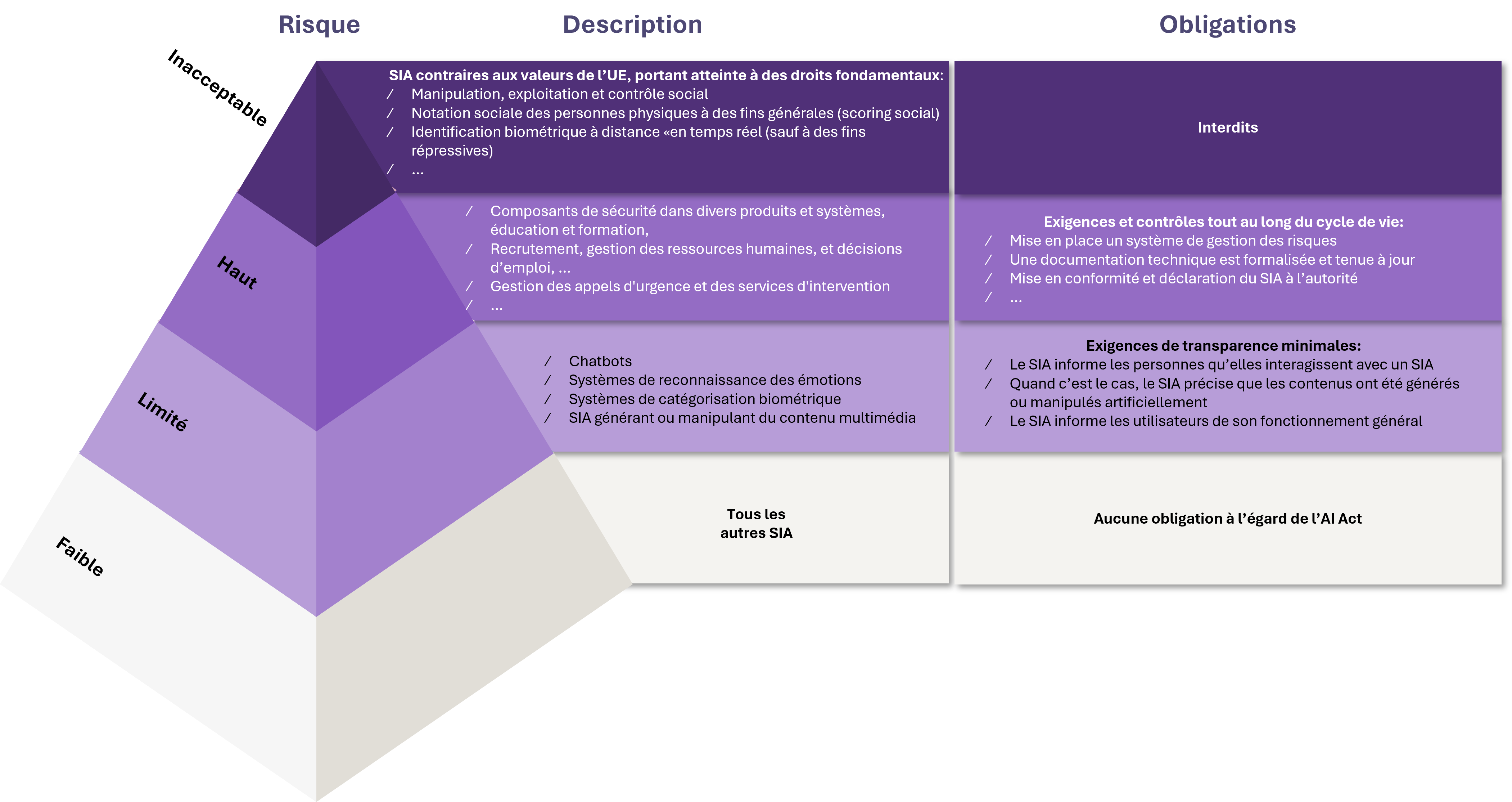

L’AI Act introduit une classification des systèmes d’intelligence artificielle. Les SIA doivent être analysés et hiérarchisés en fonction du risque qu’ils présentent pour les utilisateurs : minime, faible, haut et inacceptable. Les différents niveaux de risque impliquent plus ou moins d’obligations.

Les SIA à risque inacceptable sont interdits par l’AI Act et les SIA à risque minime n’ont pas d’obligations vis-à-vis du texte. Ce sont donc les SIA à risque haut et à risque faible qui concentrent l’essentiel des mesures prévues par le Règlement.

Des obligations particulières s’appliquent aux IA génératives et au développement de modèles d’IA à usage général (e.g. Large Language Models ou “LLMs”) selon différents facteurs : puissance de calcul, nombre d’utilisateur, utilisation d’un modèle open-source etc.

Afin de répondre aux nouveaux enjeux liés à l’émergence de l’intelligence artificielle générative, l’AI Act prévoit notamment des mesures spécifiques de cybersécurité, qui visent à réduire les risques engendrés par l’émergence de l’intelligence artificielle générative.

Dans une prochaine publication, nous reviendrons en détails sur les volets cybersécurité de l’AI Act. D’ici là, vous pouvez retrouver nos dernières publications sur l’IA et la cybersécurité : « Sécuriser l’IA : Les Nouveaux Enjeux de Cybersécurité », « L’industrialisation de l’IA par les cybercriminels, faut-il vraiment s’inquiéter ? », ou encore « Quand les mots deviennent des armes : prompt Injection et Intelligence artificielle ».

[1] Intelligence artificielle : la France accepte de valider l’AI Act après sept mois d’opposition (lemonde.fr)