Les systèmes d’IA génératives sont faillibles : en mars 2025, une faille de ChatGPT a été exploitée très largement pour piéger ses utilisateurs ; quelques mois plus tôt, c’est un chatbot santé de Microsoft qui exposait des données sensibles ; en décembre, une simple injection de prompt permettait de prendre le contrôle d’un compte utilisateur sur le service concurrent DeepSeek.

Aujourd’hui, les impacts sont limités car la latitude donnée au système d’IA est encore faible. Demain, avec l’essor de l’IA agentique, l’accélération de l’adoption de l’IA générative et la multiplication des usages, les impacts augmenteront. A l’instar des failles exploitées massivement par le rançongiciel WannaCry en 2017, des attaques cyber majeures auront certainement lieu sur les systèmes d’IA et pourraient se traduire par des blessés ou des faillites financières.

Ces risques, il s’anticipe. Un des moyens les plus pragmatiques d’y arriver, c’est d’endosser le rôle d’une personne malveillante en tentant de détourner un système d’IA pour étudier sa robustesse. Cela permet de mettre en lumière les failles du système et la façon de les corriger. Spécifiquement dans le cas de l’IA générative, cette discipline est appelée RedTeaming IA. Dans cet article, nous vous proposons d’en découvrir les contours. Nous insisterons particulièrement sur nos retours terrains concernant les principales vulnérabilités rencontrées.

Afin d’être au plus proche de ce qui se fait sur le marché, l’article se concentre exclusivement sur le RedTeaming de systèmes d’IA générative.

La GenAI, comment ça marche ?

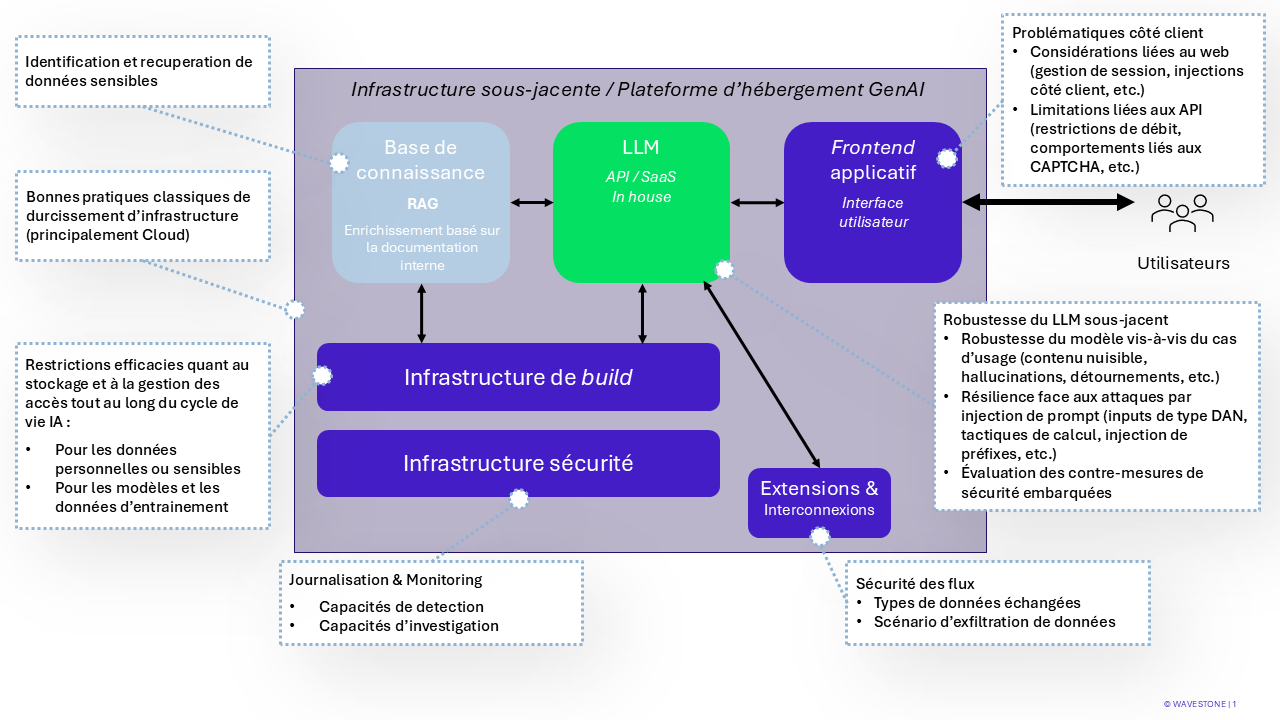

La GenAI s’appuie sur des composants qui sont souvent distribués entre des environnements cloud et on-premise. Généralement, plus un système d’IA générative offre de fonctionnalités (rechercher des informations, lancer des actions, exécuter du code, etc.), plus les composants sont nombreux. D’un point de vue cybersécurité, cela expose à de multiples risques :

Schéma d’un système d’IA générative et des problématiques soulevées par composant

En règle générale, un attaquant n’a uniquement accès qu’à une interface Web sur laquelle il peut interagir (cliquer, écrire du texte sur des champs, …). A partir de là, il peut :

- Mener des attaques de cybersécurité classiques (insertion de script malveillant – XSS, etc.) en s’appuyant sur les failles des composants du système d’IA ;

- Mener des attaques d’un genre nouveau, en écrivant en langage naturel pour détourner les fonctionnalités offertes par le système d’IA générative derrière l’interface Web : exfiltration de données, réalisation d’actions malveillantes à l’aide des privilèges du système d’IA générative, etc.

Techniquement, chacun des composants est protégé par la mise en place de mesures de sécurité définies par les processus d’Intégration de la Sécurité dans les Projets. Il est ensuite intéressant, d’évaluer en pratique le niveau de sécurité effectif lors d’un audit Redteam IA.

Le RedTeaming IA, l’art de trouver les failles des systèmes d’IA

Les audits de RedTeaming IA sont similaires aux audits de sécurité classiques. Néanmoins, afin de répondre nouveaux enjeux de la GenAI, ils s’appuient sur une méthodologie, des référentiels et un outillage spécifique. En effet, lors d’un audit RedTeam IA, il s’agit de chercher à contourner le système d’IA générative en réalisant des attaques sur ses composants ou en écrivant des instructions malveillantes en langage naturel. Cette deuxième typologie d’attaque s’appelle le prompt injection, l’art de formuler des requêtes malveillantes à un système d’IA pour en détourner ses fonctionnalités.

Lors d’un audit RedTeam IA, lors des tests d’attaques en langage naturel (propre à l’IA), deux typologies de tests sont réalisées en parallèle :

- Des tests manuels. Ils permettent une phase de reconnaissance en s’appuyant sur des bibliothèques de questions malveillantes consolidées en amont.

- Des tests outillés. Il s’agit généralement d’une IA générative qui attaque le système d’IA générative cible en générant une série de prompts malveillants et en analysant automatiquement la cohérence de la réponse du chatbot. Ils permettent de tester la robustesse du système d’IA sur un grand nombre de scénarios.

Ces tests permettent généralement d’identifier plusieurs vulnérabilités et de mettre en lumière des risques de cybersécurité souvent sous-estimés.

Quelles sont les vulnérabilités les plus rencontrées chez nos clients ?

Nous avons couvert trois grandes catégories de déploiement chez nos clients :

- Chatbot simple : ces solutions servent principalement à la redirection et au triage des demandes utilisateurs ;

- Chatbot en RAG (Retrieval-Augmented Generation): ces systèmes plus sophistiqués consultent des bases documentaires internes pour enrichir leurs réponses ;

- Chatbot agentique : ces solutions avancées peuvent interagir avec d’autres systèmes et exécuter des actions.

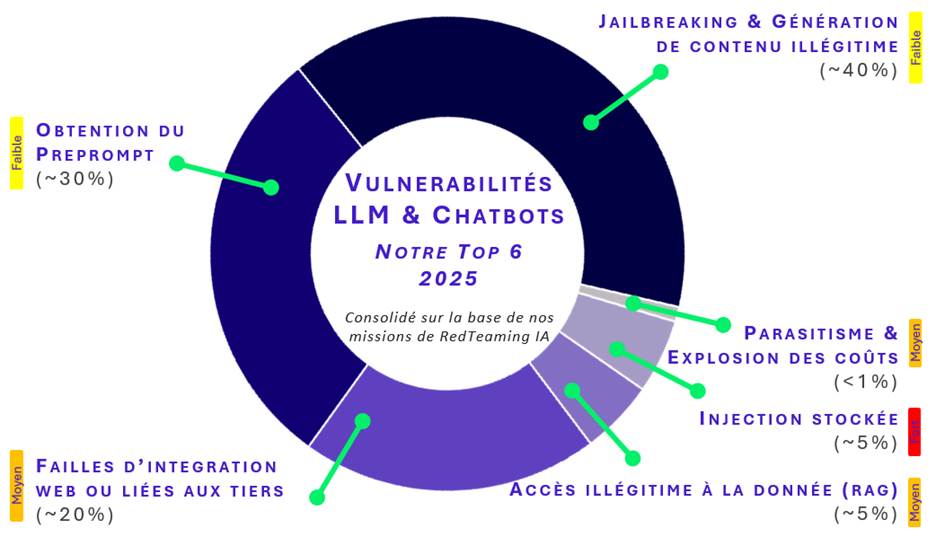

La consolidation des vulnérabilités identifiées lors de nos interventions ainsi que leur criticité relative nous permettent de définir le classement suivant :

Détournement du modèle et génération de contenu illégitime

Il s’agit du contournement des garde-fous techniques mis en place dans le développement du chatbot afin de générer du contenu offensant, malveillant, ou inadapté. C’est ainsi la crédibilité et la réputation de l’entreprise qui risquent d’être impactées puisqu’elle est responsable de la production de contenu réalisée par son chatbot.

À noter que le contournement des mécanismes de sécurité du modèle cible peut aller jusqu’à un débridage complet. On parle alors de jailbreak du modèle, ce qui le fait basculer dans un mode sans restriction. Ce dernier peut alors produire du contenu hors du cadre souhaité par l’entreprise.

Accès au preprompt

On entend par preprompt l’ensemble des instructions qui alimentent le modèle et le façonne pour l‘utilisation souhaitée. Tous les modèles ont pour consigne de ne pas divulguer ce preprompt sous quelle que forme que ce soit.

Un attaquant parvenant à accéder à ce preprompt voit son attaque facilitée car cela lui permet de cartographier les capacités du modèle du chatbot. Cette cartographie est notamment utile pour les systèmes complexes interfacés avec des APIs ou autres systèmes externes. De plus, l’accès à ce preprompt par un attaquant lui permet de visualiser la manière dont les filtres et limitations du chatbot ont été mis en place, ce qui lui permet de les contourner plus aisément.

Intégration web et intégration des tiers

Les solutions GenAI sont souvent présentées aux utilisateurs au travers d’une interface web. Les activités de RedTeaming AI mettent ainsi régulièrement en lumière des problématiques classiques des applications web, notamment le cloisonnement des sessions utilisateurs ou des attaques visant à les piéger.

Dans le cas de l’agentique, ces vulnérabilités peuvent également affecter des composants de tiers interconnectés au système GenAI.

Fuites de données sensibles

Si les données alimentant la base de connaissance interne d’un chatbot RAG sont insuffisamment consolidées (sélection, gestion, anonymisation, …), les modèles sont susceptibles de révéler involontairement des informations sensibles ou confidentielles.

Cette problématique est connexe aux aspects de gestion des droits, de classification de la donnée, et de durcissement des pipelines de préparation et de transit des données (MLOps).

Injection stockée (stored injection)

En cas d’injection stockée, l’attaquant est en mesure d’alimenter la base de connaissance d’un modèle en y incluant des instructions malveillantes (via un document piégé). Celle-ci servant aux réponses du chatbot, tout utilisateur interagissant avec le modèle et sollicitant ledit document verra sa session compromise (fuite des données d’historique de conversation des utilisateurs, redirections malveillantes, participation à une attaque d’ingénierie sociale, …).

Les documents piégés pourront être particulièrement compliqués à identifier, notamment dans le cas de bases de connaissances larges ou peu maitrisées. Cette attaque est ainsi persistante et furtive.

Mention honorable : parasitisme et explosion des coûts

On parle de parasitisme lorsqu’un utilisateur est en mesure de débrider le chatbot afin d’utiliser pleinement les capacités du modèle, et ce gratuitement. Couplé à une absence de restriction volumétrique, un utilisateur peut réaliser un nombre prohibitif de requêtes, sans lien avec le cas d’usage initial et néanmoins facturés.

De manière générale, certaines des vulnérabilités mentionnées concernent des risques relativement mineurs, dont l’impact métier pour les systèmes d’information (SI) est limité. Néanmoins, avec les avancées des technologies IA, ces vulnérabilités prennent une autre dimension, notamment dans les cas suivants :

- Les solutions agentiques ayant accès à des systèmes sensibles

- Les applications RAG impliquant des données confidentielles

- Les systèmes pour lesquels les utilisateurs ont la main sur les documents de la base de connaissance, ouvrant la porte aux injections stockées

Les systèmes GenAI testés sont débridables en très large majorité, bien que l’exercice se complexifie avec le temps. Cette incapacité persistante des modèles à mettre en place des restrictions efficaces incite l’écosystème IA à se tourner vers des briques de sécurité externes.

Quelles nouvelles surfaces d’attaque ?

L’intégration croissante de l’IA dans des secteurs d’activité sensibles (santé, finance, défense, …) augmente les surfaces d’attaque des systèmes critiques, ce qui renforce le besoin de filtrage et d’anonymisation des données sensibles. Là où les applications IA étaient jusqu’à présent très cloisonnées, l’IA agentique met fin à ce cloisonnement puisqu’elle déploie une capacité d’interconnexion, ce qui ouvre la porte à de possibles propagations de menaces au sein des SI.

La baisse du niveau technique requis pour créer un système d’IA, notamment au travers de l’usage des plateformes SaaS et services Low/no code, en facilite l’usage tant pour des utilisateurs légitimes que pour des attaquants.

Enfin, la généralisation des « copilotes » directement sur les postes des collaborateurs se traduit par un usage croissant de composants de plus en plus autonomes qui agissent à la place de et avec les privilèges d’un humain, accélérant l’apparition de périmètres IA non-maitrisés ou Shadow IT IA.

Vers des systèmes de plus en plus difficiles à maitriser

Bien qu’imitant l’intelligence humaine en apparence, les modèles de GenAI (LLM, pour Large Langage Model) ont pour fonction unique d’imiter le langage et agissent finalement bien souvent comme des systèmes d’auto-complétion textuelle hautement performants. Ces systèmes ne sont nativement pas entrainés pour raisonner et leur utilisation se heurte à un fonctionnement en « boite noire ». Il est en effet complexe d’expliquer de manière fiable leur raisonnement, ce qui se traduit régulièrement par des hallucinations dans leurs productions, ou des contresens logiques. En pratique, il est également impossible de prouver l’absence de « porte dérobées » (backdoor) dans ces modèles, limitant encore davantage notre confiance dans ces systèmes.

L’émergence de l’IA agentique complexifie la situation. En interconnectant des systèmes au fonctionnement opaque, elle rend l’ensemble du processus de raisonnement généralement invérifiable et inexplicable. Les cas de modèle entrainant, auditant ou attaquant d’autres modèles se généralisent, ce qui induit une problématique de confiance majeure lorsqu’ils sont intégrés aux systèmes d’information des entreprises.

Quelles perspectives pour la suite ?

Les audits de RedTeaming IA menés sur des systèmes d’IA générative révèlent une réalité contrastée. D’un côté, l’innovation est fulgurante, portée par des cas d’usage de plus en plus puissants et intégrés. De l’autre, les vulnérabilités identifiées démontrent que ces systèmes, souvent perçus comme intelligents, restent largement manipulables, instables et peu explicables.

Ce constat s’inscrit dans un contexte plus large de démocratisation des outils IA couplée à leur autonomie croissante. L’IA agentique, en particulier, fait apparaître des chaînes d’action difficilement traçables, agissant avec des privilèges humains. Dans un tel paysage, le risque n’est plus uniquement technique : il devient aussi organisationnel et stratégique, impliquant une gouvernance et une supervision continue de ses usages.

Face à ces défis, le RedTeaming IA s’impose comme un levier essentiel pour anticiper les déviances possibles, en adoptant le point de vue de l’attaquant pour mieux prévenir les dérives. Il s’agit de tester les limites d’un système pour concevoir des mécanismes de protection robustes, pérennes, et alignés avec les nouveaux usages. C’est à ce prix que l’IA générative pourra continuer à évoluer dans un cadre de confiance, au service des utilisateurs comme des organisations.