Et si vos données les plus sensibles devenaient accessibles en un instant ?

L’effervescence croissante au sujet de l’avènement des ordinateurs quantiques est justifiée pour un sujet qui ne relève plus de la science-fiction, mais qui implique une menace d’un nouveau genre.

En effet, selon les prévisions de nombreux experts tels que le Global Risk Institute, les ordinateurs quantiques devraient prochainement être capables de résoudre les problèmes mathématiques qui sous-tendent les standards cryptographiques actuels – ce qui, en conséquence, rendrait obsolètes les systèmes classiques protégeant nos communications, nos finances et nos infrastructures critiques.

Pour les entreprises, l’urgence n’est plus de se demander si cette menace deviendra réalité, mais quand. Comment anticiper les impacts opérationnels et structurels de ce bouleversement technologique tout en répondant aux recommandations croissantes des régulations à ce sujet ? Quels outils adopter pour garantir la confidentialité et l’intégrité des données dans un futur proche ? Le défi est de taille, mais des solutions sont à l’étude comme la cryptographie post-quantique (PQC), déjà massivement plébiscitée par la communauté internationale.

La menace quantique

Aujourd’hui, la sécurité des systèmes d’information repose principalement sur la cryptographie symétrique, asymétrique (ou à clé publique) et les fonctions de hachage. Ces catégories sont représentées par des algorithmes largement utilisés aujourd’hui, en particulier AES, RSA, ECC, ainsi que SHA pour les fonctions de hachage. Adoptés massivement par la communauté mondiale et intégrés nativement dans de nombreux dispositifs modernes, ces algorithmes ont fait leurs preuves depuis des décennies pour assurer la confidentialité, l’authenticité et l’intégrité des échanges de données.

Les problèmes mathématiques sur lesquels sont basés ces standards présentent un niveau de complexité de calcul suffisant pour assurer l’absence de capacité de brute-force même avec les meilleurs supercalculateurs actuels.

L’ordinateur quantique vient rebattre ces cartes.

Ces machines reposent sur des principes physiques fondamentalement différents des ordinateurs classiques actuels. Grâce aux phénomènes de superposition et d’intrication, un processeur quantique peut traiter simultanément différents états physiques. Ce que l’on décrit souvent comme du « parallélisme quantique » ne correspond pas à un simple calcul parallèle classique (où plusieurs cœurs exécutent des tâches identiques), mais à la capacité d’explorer simultanément de multiples chemins d’exécution. Pour certains algorithmes, cette approche permet de réduire considérablement l’espace de recherche et d’accélérer le traitement.

Une question essentielle se pose alors : existe-t-il déjà des algorithmes capables d’exploiter ces propriétés quantiques, et ainsi de venir à bout des standards de chiffrement actuels ?

En 1994, P. Shor, suivi de L. Grover en 1996, introduisent des algorithmes intégrant des processus de calcul quantique pour résoudre certains problèmes mathématiques complexes. Le premier permet de factoriser de grands nombres de manière exponentiellement plus rapide qu’un algorithme classique, tandis que le second optimise la recherche d’un élément dans des ensembles non ordonnés. Si les caractéristiques des ordinateurs classiques rendaient jusque-là leur mise en œuvre impraticable, l’émergence des ordinateurs quantiques changerait radicalement la donne, rendant ces algorithmes exploitables.

En effet, le meilleur supercalculateur mettrait 1.02 x 10¹⁸ ans (un trillion d’années) pour casser AES-128 par force brute et 10¹⁰ ans (10 milliards d’années) pour RSA-2048 avec les meilleures méthodes actuelles. En comparaison, un ordinateur quantique exécutant l’algorithme de Grover pourrait briser AES-128 en 600 ans, tandis que l’algorithme de Shor viendrait à bout de RSA-2048 en seulement 8 heures avec une machine de 20 millions de qubits.

Face à cette menace, AES et la cryptographie symétrique, ainsi que SHA-256 et les fonctions de hachages restent viables en doublant la taille des clés utilisées, mais la cryptographie asymétrique doit être repensée. Dans cette optique, la cryptographie post-quantique s’impose comme la solution la plus prometteuse.

Qu’est-ce que la cryptographie post-quantique ?

Selon l’ANSSI, « la cryptographie post-quantique (PQC) est un ensemble d’algorithmes cryptographiques classiques comprenant les établissements de clés et les signatures numériques, et assurant une sécurité conjecturée vis-à-vis de la menace quantique en plus de leur sécurité classique ».

Cela désigne donc l’ensemble des nouveaux algorithmes de chiffrement asymétriques capables de garantir la sécurité à la fois face aux attaques classiques, et face aux nouvelles attaques quantiques. La différence avec ceux que nous utilisons aujourd’hui réside essentiellement dans les problèmes mathématiques sous-jacents aux algorithmes, choisis pour rester complexes à résoudre, même pour un ordinateur quantique.

Pourquoi cette solution est-elle considérée comme la plus prometteuse ?

La PQC n’est pas la seule réponse envisagée face à la menace quantique, mais elle est largement considérée comme étant la solution la plus viable selon la communauté internationale. Plusieurs facteurs expliquent cet intérêt, parmi lesquels on retrouve :

- Une continuité avec les systèmes actuels, facilitant son adoption et son intégration progressive dans les infrastructures classiques.

- Une maturité avancée, avec des standards déjà établis et soutenus par les principales autorités en cybersécurité.

Une continuité avec les systèmes actuels

Comment cette cryptographie de nature classique permet-elle de protéger les données chiffrées face aux attaques quantiques ?

La PQC n’implique pas un changement de paradigme dans notre approche de sécurisation des infrastructures. Comme évoqué plus tôt, la PQC s’inscrit dans la famille de la cryptographie asymétrique et conserve donc le même fonctionnement et objectif que les algorithmes à clé publique actuels. Sa résistance face aux attaques quantiques est assurée par la nature des problèmes mathématiques sous-jacents, différents de ceux utilisés par la cryptographie asymétrique classique. Cette différence structurelle permet également une intégration plus fluide de cette cryptographie dans les infrastructures numériques actuelles, assurant ainsi une transition progressive vers un avenir où la PQC supplanterait totalement et efficacement les standards de chiffrement modernes.

Une maturité avancée

Le deuxième atout majeur de la PQC est sa maturité par rapport aux autres options envisagées. En effet, cette année a été marquée la publication des standards de PQC par le National Institute of Standards and Technology (NIST) américain en août 2024.

Ce processus a débuté en 2017 avec 69 candidats initiaux, dont 4 ont été retenus afin de devenir les nouveaux standards de PQC. Aucune des autres solutions évoquées pour contrer la menace à venir, parmi lesquelles se trouve la cryptographie quantique (basée sur l’usage des propriétés quantiques en opposition à la PQC, dont les implémentations sont possibles sur des ordinateurs classiques), n’ont été l’objet d’un processus de standardisation.

De surcroît, les organismes de cybersécurité nationaux tels que l’ANSSI (France), la BSI (Allemagne), la NLNCSA (Pays-Bas), la SFA (Suède), le NCSC (UK), la NSA (USA) etc. s’accordent tous à dire que la PQC est la meilleure façon de se prémunir contre la menace quantique, et que la priorité des entreprises doit être la migration vers des systèmes de PQC.

Quand et comment mettre en place cette technologie ?

Les prédictions des organismes de recherche sur l’avènement de la menace quantique restent encore assez disparates, mais s’accordent néanmoins à annoncer que des ordinateurs quantiques capables d’exécuter des algorithmes responsables de la future désuétude des standards de cryptographie actuelle, appelés en anglais Cryptographically Relevant Quantum Computer (CRQC) rendront obsolètes RSA-2048 notamment, d’ici les 15 prochaines années. En effet, il est difficile de prédire avec exactitude quand l’ordinateur quantique sera prêt et atteindra des performances suffisantes pour des cas d’usage concrets, mais les croisements entre les recommandations d’organismes comme la la NSA et les prédictions d’experts sur le sujet nous permettent d’estimer l’émergence des premiers CRQC entre 2033 et 2037.

Harvest now, decrypt later

Nous ne disposons pas pour autant de 10 ans devant nous pour nous armer face à cette menace. Les données en transit actuellement restent exposées aux attaques de type « harvest now, decrypt later ». Ce sont des attaques reposant sur l’interception et le stockage à long terme de données chiffrées, dans l’attente des percées technologiques en matière de décryptage qui les rendraient lisibles à l’avenir.

Les données ciblées par ce type d’attaques sont principalement des données en transit, car c’est lors de leur transport que des protocoles comme TLS utilisent des paires de clés asymétriques. C’est à ce moment que la donnée est « vulnérable au quantique » et donc intéressante à intercepter puis stocker afin de la déchiffrer ultérieurement. Les données au repos sont au contraire généralement chiffrées à l’aide d’algorithmes symétriques, et requiert d’être exfiltrées pour être capturées, elles ne sont donc pas la cible de ces attaques.

Le risque principal de ces attaques demeure la violation de la confidentialité à long terme de données. Selon les secteurs, notamment financier ou industriel, les données peuvent rester sensibles sur de longues périodes et par conséquent l’accès à ces informations peut entraîner des conséquences multiples graves.

Il est raisonnable de considérer que des attaquants pourraient actuellement récupérer une quantité considérable de données chiffrées afin de les décrypter ultérieurement. Dès lors, il est impératif d’amorcer une migration vers des systèmes cryptographiques résistants aux algorithmes quantiques dès aujourd’hui.

Recommandations des organismes au sujet de la préparation

La CISA, la NSA et le NIST américain pour ne citer qu’eux, exhortent les entreprises à se préparer dès maintenant en établissant une feuille de route quantique, pilotée par une équipe projet dédiée, dont le but serait de planifier et superviser la migration de l’organisation vers la PQC.

Le cadrage du projet devra être axé sur ces 3 volets principaux :

- Inventaire cryptographique : l’objectif est de comprendre l’exposition de l’organisation aux mécanismes cryptographiques vulnérables. Cela passe par l’identification des technologies utilisées au sein des systèmes, des protocoles réseaux, des applications, et des bibliothèques de programmation.

- Analyse de risques : cet axe vise à prioriser les actifs et processus à sécuriser en premier. Il s’agit d’évaluer la criticité des données protégées, mais aussi d’anticiper leur durée de protection nécessaire. Cette analyse repose sur l’inventaire cryptographique fait en amont et permet de cibler les efforts là où l’impact d’une attaque quantique serait le plus critique.

- Responsabilité des fournisseurs : la transition vers la cryptographie post-quantique implique également un travail étroit avec les partenaires technologiques. Les entreprises doivent s’assurer de la crypto-agilité des solutions qu’elles utilisent : les produits actuels pourront-ils être mis à jour vers des systèmes résistants à la menace quantique ou devront-ils être remplacés pour éviter l’obsolescence ?

La stratégie de migration que nous préconisons chez Wavestone reprend les grandes étapes évoquées par la CISA, la NSA et le NIST, et les approfondit en les adaptant aux réalités opérationnelles de chaque entreprise :

- Phase stratégique :

- Compréhension et sensibilisation : Premièrement, il s’agit de former et d’informer l’ensemble des acteurs (direction, équipes métiers, équipes techniques) sur l’impact de la menace quantique, les enjeux liés à la cryptographie post-quantique, ainsi que sur les grandes orientations réglementaires.

- Évaluation des risques et inventaire initial : Cartographie des usages cryptographiques (protocoles, bibliothèques, applications, etc.) et identification des données sensibles devant rester confidentielles sur une longue période. C’est également à ce stade que l’on évalue la maturité de l’entreprise et qu’on priorise les chantiers les plus critiques.

- Cadrage du programme : Sur la base des risques identifiés, la feuille de route globale (objectifs, budget, organisation) est définie. Une équipe dédiée – ou “centre d’excellence” – est créée pour piloter la transition, coordonner les différents chantiers et définir les indicateurs de succès.

- Quick wins

- Avant d’entrer dans une phase de transformation plus lourde, nous préconisons de lancer rapidement des initiatives à faible investissement, par exemple inclure des clauses post-quantiques dans les contrats (fournisseurs, partenaires). L’objectif est d’obtenir des retours concrets, de sensibiliser davantage les parties prenantes et de créer une dynamique positive autour du projet.

- Programme de transition

- Test d’un premier cas d’usage : Sélection d’un cas d’usage représentatif pour déployer, en conditions réelles, les premiers algorithmes ou mécanismes de cryptographie post-quantiques.

- Inventaire détaillé (seconde itération) : Il faut ensuite affiner la cartographie des composants cryptographiques (PKI, gestion de clés, protocoles réseaux, librairies de chiffrement, etc.) afin de planifier précisément la migration.

- Modernisation de la “confiance numérique” : Il s’agit d’actualiser les infrastructures (PKI, gestion de certificats, politiques de rotation de clés…) et de mettre en place des procédures permettant d’accueillir les nouveaux algorithmes.

- Migration et veille : Déploiement progressif des algorithmes post-quantiques sur les systèmes critiques, tout en maintenant la continuité de service. Cette phase s’accompagne de contrôles, de tests de performance et de vérifications de sécurité. À terme, l’ensemble du SI est couvert, garantissant la pérennité et la conformité réglementaire.

Cette feuille de route, à la fois pragmatique et en phase avec les préconisations des organismes compétents, garantit une transition maîtrisée vers la cryptographie post-quantique.

L’hybridation évoquée en Europe comme une étape importante dans la transition

L’ANSSI dans une publication commune avec plusieurs de ses homologues européens BSI, NLNCSA, SNCSA, et SFA, recommandent également une préparation à cette transition devant débuter le tôt possible. Bien que les nouveaux standards de PQC incluant les algorithmes, les instructions d’implémentation, et leur utilisation, ont été publiés par le NIST en août 2024, ces organismes n’encouragent pas l’intégration immédiate de ces algorithmes dans les systèmes cryptographiques des entreprises. L’ANSSI annonce même « n’approuver aucun remplacement direct à court ou moyen terme ». En cause, « un manque de recul cryptanalytique sur plusieurs aspects de sécurité » ; malgré son processus de standardisation terminé, la PQC n’est pas encore considérée suffisamment mature pour garantir la sécurité à elle seule :

- Plusieurs algorithmes finalistes (et donc jugés comme prometteurs) du processus de standardisation du NIST ont été l’objet d’attaques classiques ayant abouties. L’algorithme SIKE dont on est venu à bout en 10min, et Rainbow en un week-end.

- Le dimensionnement, l’intégration des algorithmes dans des protocoles de communication, et la conception d’implémentations sécurisées sont d’autres aspects sur lesquels il faut progresser selon l’ANSSI.

Par conséquent, au contraire du NIST, l’ANSSI mais également la BSI entre autres, recommande l’adoption de systèmes hybrides par les organisations. C’est un concept qui consiste à « combiner des algorithmes asymétriques post-quantiques avec une cryptographie asymétrique pré-quantique bien connue et bien étudiée » ANSSI. Ainsi, l’on peut bénéficier de l’efficacité des standards actuels sur les attaques classiques, et de la résistance conjecturée de la PQC sur les attaques quantiques.

L’hybridation est possible pour les mécanismes d’encapsulation de clés et pour les signatures numériques. Chaque opération classique est remplacée soit par :

- l’exécution successive,

- l’exécution en parallèle des 2 algorithmes, pré-quantique et quantique.

La deuxième option peut être implémentée dans le but de réduire la perte de performance du système. Ces schémas hybrides nécessitent par ailleurs que les acteurs impliqués supportent les deux types d’algorithmes.

C’est un schéma dont « le surcoût de performance d’un schéma hybride reste faible par rapport au coût du schéma post-quantique ». L’ANSSI estime « qu’il s’agit d’un prix raisonnable à payer pour garantir une sécurité pré-quantique au moins équivalente à celle apportée par les algorithmes normalisés pré-quantiques actuels ».

Outre-manche et Atlantique, on est beaucoup plus nuancé que les homologues européens sur la question. Bien que l’intérêt de l’hybridation soit reconnu par les autorités de cybersécurité anglaise et étatsunienne, le NCSC et le NIST insiste sur le caractère temporaire de cette solution et n’imposent pas l’hybridation comme étape obligatoire avant de migrer totalement vers la PQC. La NSA dit explicitement avoir confiance dans les standards de PQC et ne requiert pas l’utilisation de modèles d’hybridation dans les systèmes de sécurité nationaux. En résumé, la décision d’utiliser ces modèles doit être prise en tenant compte :

- des contraintes techniques d’implémentation,

- de la complexité accrue (deux algorithmes au lieu d’un),

- du coût additionnel,

- de la nécessité de transitionner une seconde fois à l’avenir vers un système de PQC total, , ce qui peut constituer un exercice complexe de crypto-agilité – c’est-à-dire la capacité de modifier rapidement et sans bouleversements majeurs son infrastructure cryptographique en réponse à l’évolution des menaces – pour certaines entreprises.

Aspect règlementaire

Il n’y a actuellement pas de règlementation européenne qui formule d’exigences explicites au sujet de la cryptographie post-quantique. Néanmoins, parmi les différents textes évoquant le chiffrement de données (NIS2, DORA, HDS…), certains exigent explicitement de l’appliquer à l’état de l’art. DORA impose notamment la mise à jour constante des moyens cryptographiques utilisés par rapport à l’évolution des techniques de cryptanalyse. Il est donc possible de considérer cela comme un premier pas pour guider les organisations vers le concept de crypto-agilité.

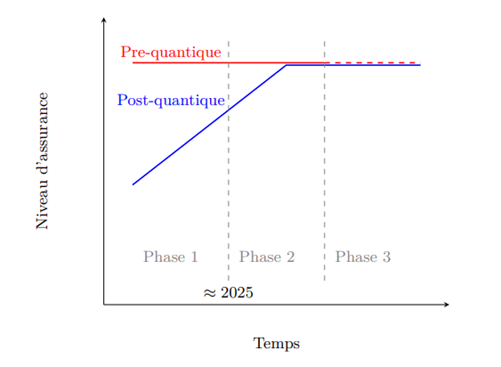

Malgré cette absence d’exigences actuellement, l’ANSSI prévoit un plan de transition post-quantique en 3 phases :

- Phase 1 (en cours)

La sécurité post-quantique effective à travers l’hybridation reste facultative et est considérée par l’agence comme une défense en profondeur. Les visas de sécurité délivrés par l’ANSSI restent inchangés et garantissent uniquement la sécurité pré-quantique.

- Phase 2 (après 2025)

La résistance quantique devient une propriété de sécurité. Des critères de sécurité post-quantique pour les algorithmes de PQC auront été définis par l’ANSSI, et seront pris en compte dans la délivrance de visas de sécurité.

- Phase 3 (après 2030)

On estime que le niveau d’assurance de sécurité post-quantique sera équivalent au niveau pré-quantique actuel. L’hybridation deviendra donc optionnelle ; des visas de sécurité pourront être délivrés pour des entreprises utilisant des schémas post-quantiques sans hybridation.

En outre, suivant le contexte, l’ANSSI pourra décider de n’octroyer ses visas de sécurité que pour la sécurité à long terme post-quantique.

Aux Etats-Unis, le plan de transition post-quantique du NIST n’est pas définitif, mais l’obsolescence de RSA et ECC est d’ores et déjà projeté pour 2030, suivi d’une interdiction d’implémentation totale en 2035 ; d’où l’objectif annoncé – aligné avec la NSA – pour l’achèvement de la migration vers la PQC dans l’ensemble des systèmes fédéraux la même année. Selon les exigences des différents secteurs, il sera peut-être nécessaire de transitionner plus rapidement selon les niveaux de risque associés.

Même si 2035 semble être un horizon lointain, la migration complète vers la cryptographie post-quantique est un long processus, et les phases initiales d’inventaire cryptographique, classification de données et d’analyse de risques notamment, requièrent un temps considérable. Par conséquent, il est essentiel de démarrer dès aujourd’hui afin de planifier une transition réussie.

L’avènement des ordinateurs quantiques n’est donc plus une hypothèse lointaine, mais une certitude qui redéfinira les fondations de la cybersécurité. Si le timing précis (2033-2037) reste incertain , la pression règlementaire impulsée par les institutions de cybersécurité se précise, et les impacts sur la confidentialité et l’intégrité des données sont, eux, inéluctables. Chaque jour qui passe sans adaptation renforce la vulnérabilité des entreprises face aux attaques futures.

Pourtant, des solutions existent déjà : la cryptographie post-quantique, bien que peu mature à date – surtout dans ses implémentations – offre une réponse prometteuse à cette menace. Standardisée et soutenue par les plus grandes instances internationales, elle incarne la première étape vers une sécurité pérenne à l’ère quantique.

Cependant, adopter cette technologie ne se limite pas à un simple déploiement technique. C’est une transition stratégique, un exercice de crypto-agilité , et une opportunité pour les entreprises d’affirmer leur résilience face aux bouleversements technologiques.

La question n’est plus de savoir si votre organisation sera prête lorsque le premier ordinateur quantique capable de briser RSA-2048 verra le jour. Il s’agit de savoir si elle aura su anticiper ce futur, en s’armant dès maintenant des outils et des plans nécessaires pour transformer cette contrainte en un avantage compétitif. Le futur de la sécurité commence aujourd’hui.