L’intelligence artificielle (IA) transforme de nombreux secteurs dont celui de l’industrie. Ses déclinaisons les plus récentes, notamment celles basées sur le Machine Learning (ML), comme l’IA générative, ouvrent la voie à de nouvelles opportunités en matière d’automatisation des processus, d’optimisation des chaînes logistiques, de personnalisation, etc… Ces avancées permettent aux entreprises de gagner en efficacité, de réduire les coûts, d’améliorer l’expérience utilisateur, tout en innovant et en gagnant en compétitivité.

Cependant, cette évolution met en lumière les problématiques de cybersécurité spécifiques à ces systèmes, poussant les entreprises du secteur industriel à mener des réflexions sur la sécurisation de ces usages.

Quelles opportunités sont amenées par l’Intelligence Artificielle dans le secteur industriel ?

Quelles opportunités l’Intelligence Artificielle apporte-t-elle ? Et quels sont les éventuels risques de cybersécurité que cela apporte ?

IA & Industrie

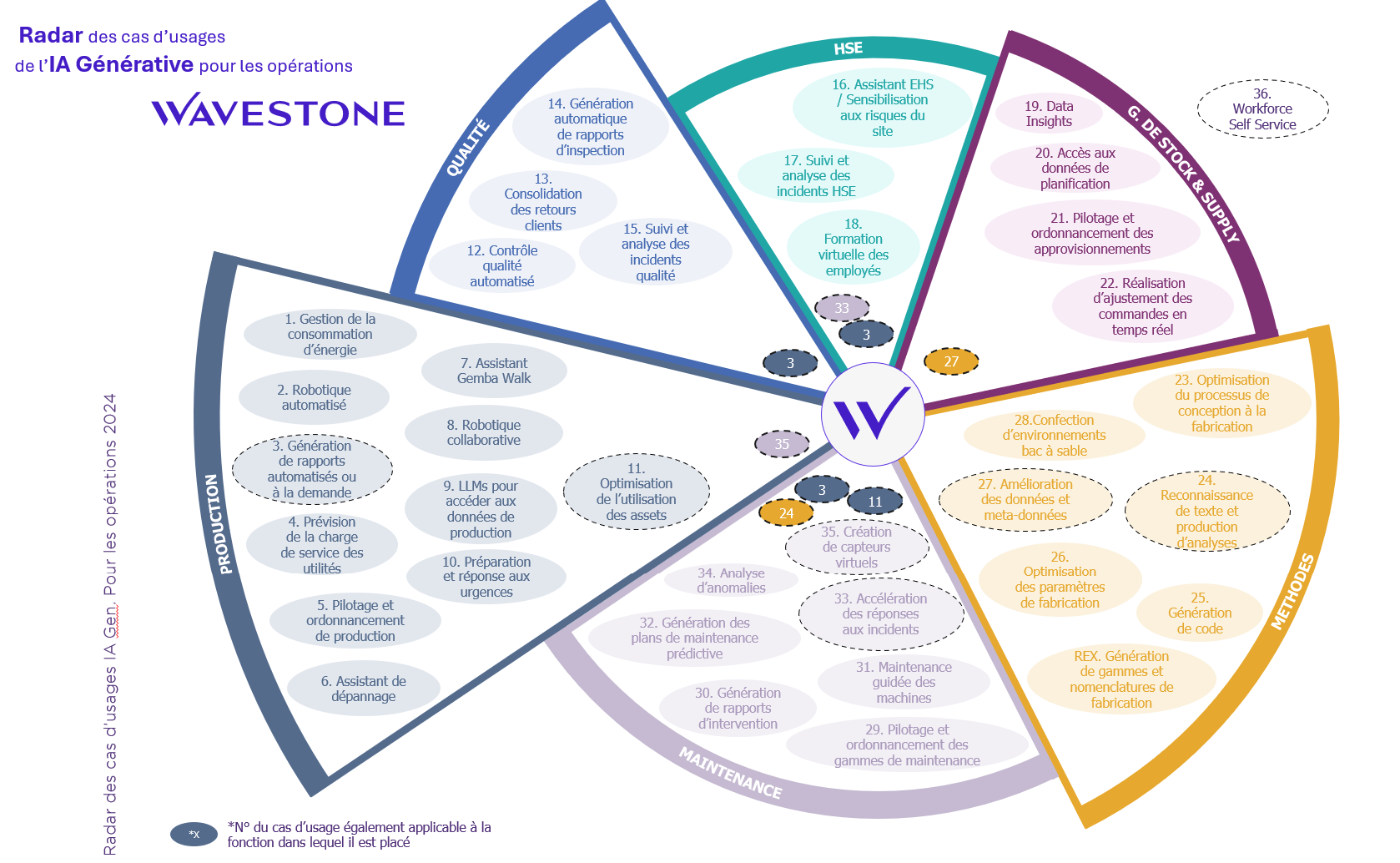

Pour mieux comprendre l’étendue des possibilités offertes par ces technologies, Wavestone a établi le Radar des cas d’usages de l’IA générative pour les opérations 2024, répertoriant les tendances d’utilisation observées chez ses clients industriels, ainsi que d’autres cas d’usage susceptibles de se développer dans les prochaines années :

Figure 1 – Radar des cas d’usages d’IA générative pour les opérations

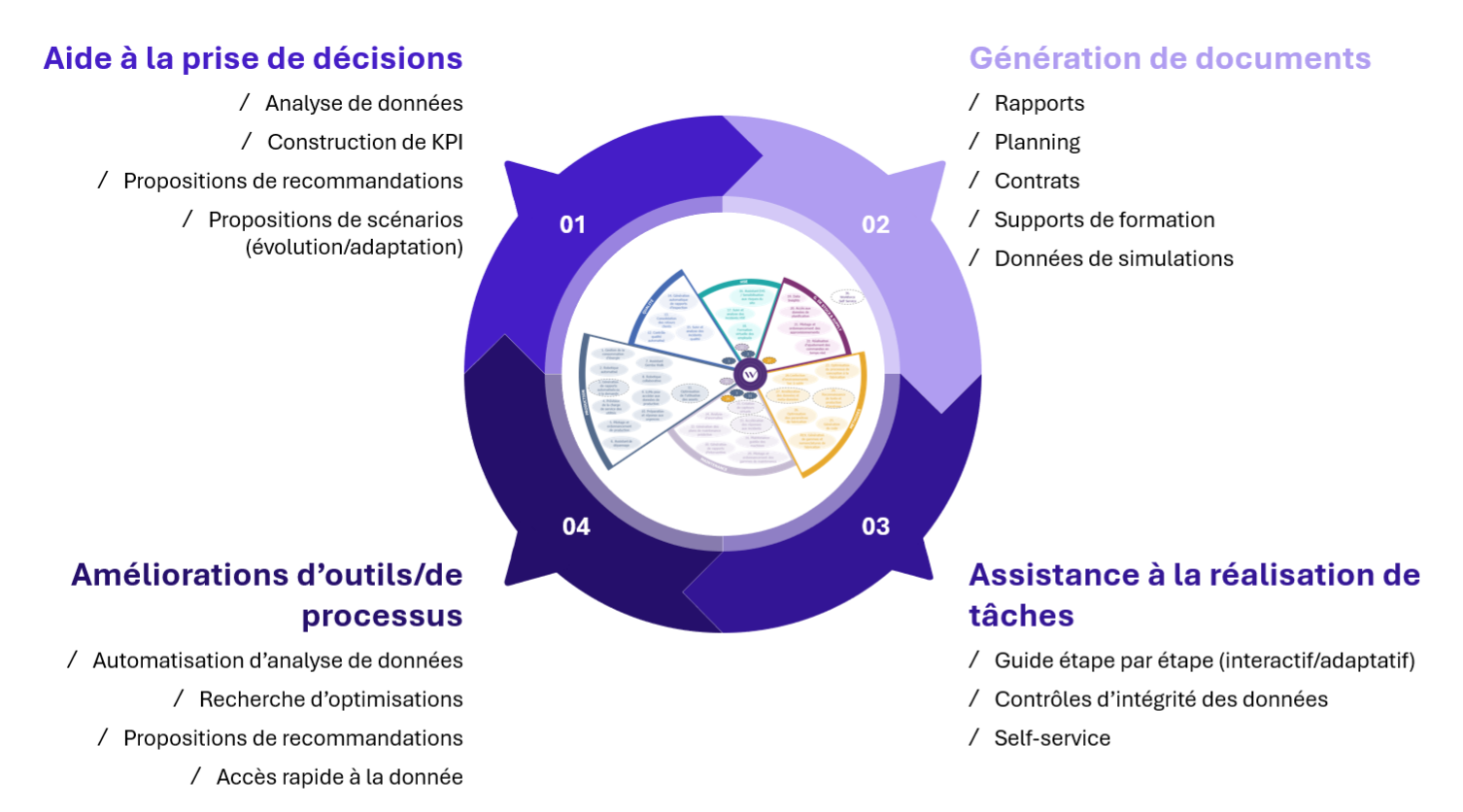

Wavestone a identifié 4 typologies d’usage (aide à la prise de décision, amélioration d’outils et de processus, génération de documents, assistance à la réalisation de tâches) impactant plusieurs fonctions industrielles (production, qualité, maintenance, gestion des stocks, chaîne d’approvisionnement, etc.).

Figure 2 – Typologies d’usage d’IA générative pour les opérations

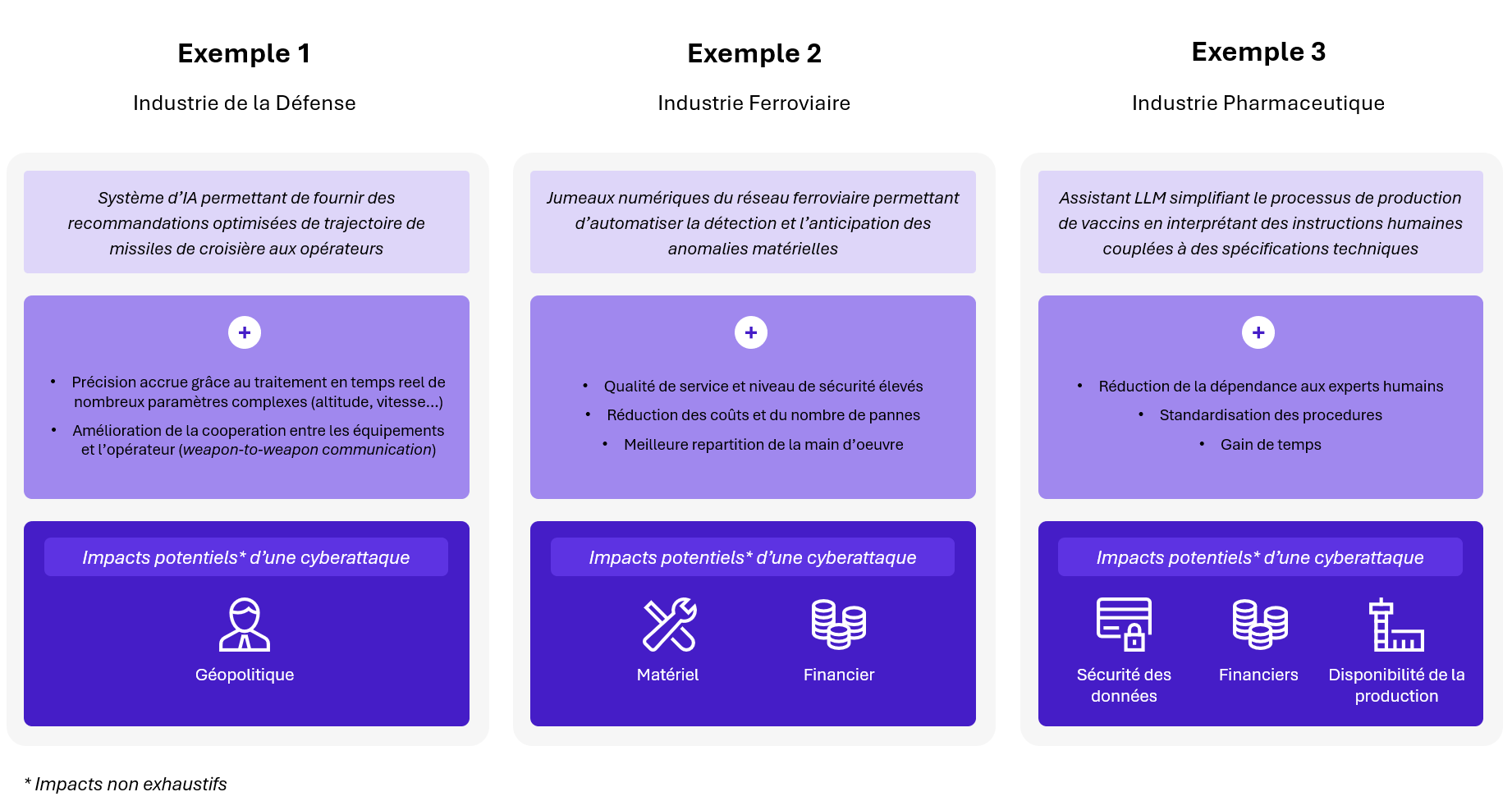

Voici quelques exemples concrets illustrant comment ces technologies s’intègrent aux opérations de divers secteurs, ce qu’elles apportent, tout en mentionnant les impacts que peuvent engendrer des cyberattaques sur ces systèmes :

Figure 3 – Cas d’usage d’IA existants dans le secteur industriel

Ces systèmes permettent d’obtenir des avantages technologiques et stratégiques, des gains financiers ou de temps non négligeables.

Néanmoins, l’intégration de ces technologies peut ouvrir la porte à de nouveaux risques qui doivent être pris en compte par les entreprises.

Cyber risques de l’IA

Comment un attaquant peut-il compromettre ces systèmes ?

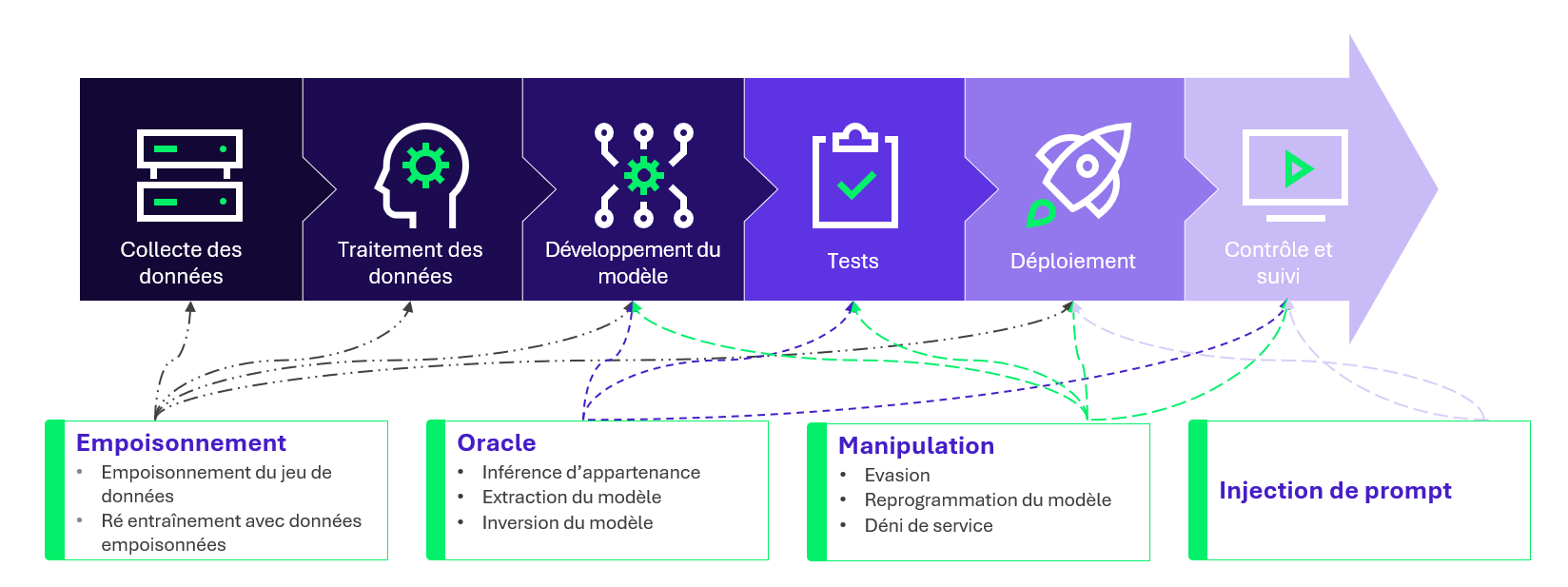

Il existe plusieurs catégories d’attaques spécifiques à l’IA, toutes exploitant des failles présentes dans les différentes phases du cycle de vie de ces modèles, offrant une large surface d’attaque :

Figure 4 – Cycle de vie d’un modèle d’IA : attaques possibles

La majorité de ces attaques cherchent à détourner l’IA de son usage prévu. Les objectifs peuvent être d’en extraire des informations confidentielles, ou encore de lui faire exécuter des actions non autorisées, compromettant ainsi la sécurité et l’intégrité des systèmes.

Pour comprendre ces attaques dans les détails, nos experts ont illustré des méthodes par évasion et par oracle dans un article dédié au sujet.

Qu’en est-il de ces risques pour les entreprises industrielles ?

En réalité, les risques liés à l’IA dans l’industrie varient considérablement selon le secteur et l’utilisation qui en est faite.

Pour mener des attaques par oracle, manipulation et injection de prompt contre une IA, il est nécessaire de pouvoir interagir avec elle en lui fournissant des données d’entrée. Cela est possible avec certaines IA génératives, comme ChatGPT, qui nécessitent des requêtes textuelles. En revanche, d’autres systèmes, tels que ceux utilisés pour la maintenance prédictive (solutions permettant d’anticiper et de prévenir les pannes d’équipements), ne dépendent pas d’instructions humaines pour fonctionner, rendant les interactions plus complexes. De plus, les types de données d’entrée de ces systèmes sont souvent très spécifiques, difficiles à obtenir, et à manipuler.

Des attaques par empoisonnement des données d’entraînement pourraient être réalisées sur ces systèmes. Cependant, cela nécessiterait d’abord de s’introduire dans les SI, comprendre en profondeur le fonctionnement de l’IA, puis de tenter d’altérer son comportement, sans garantie de succès. De plus, les entreprises dotées d’un bon niveau de cybersécurité disposent déjà de contre-mesures et de moyens de protection, réduisant considérablement les chances de réussite d’une telle attaque.

En comparaison, d’autres méthodes ne ciblant pas spécifiquement l’IA sont plus simples à mettre en place et peuvent augmenter les chances d’un attaquant de causer des dommages à une entreprise.

Toutefois, d’autres applications de l’IA sont vulnérables à ces types d’attaques. Par exemple, un assistant utilisant de l’IA générative, avec lequel un humain peut interagir, est susceptible de subir des manipulations ou des injections de données.

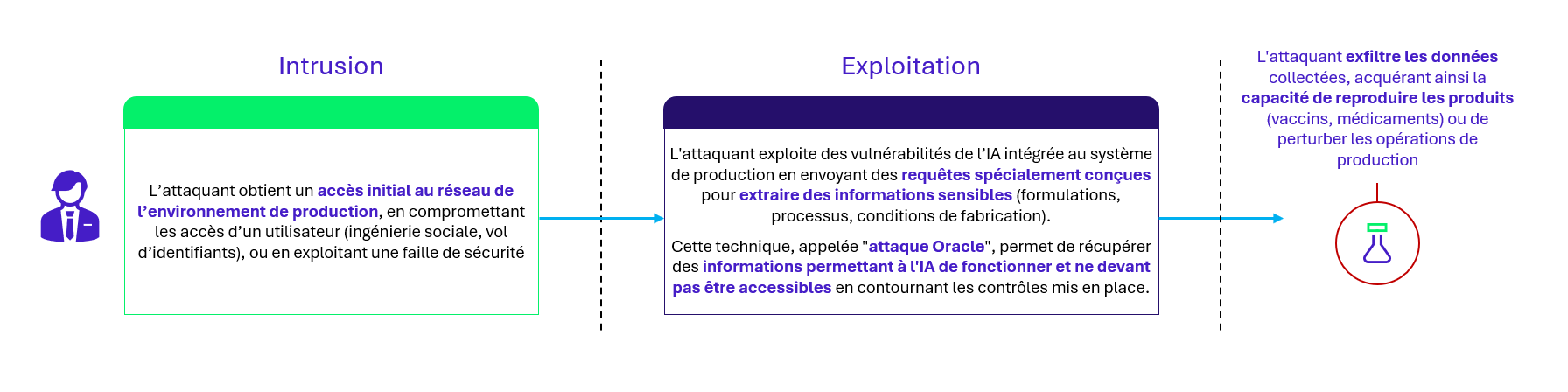

Voici un exemple de scénario d’attaque sur l’assistant à la production de vaccins présenté en Figure 3.

Contexte du cas d’usage

Les employés écrivent leur demande à l’assistant et y joignent les spécifications du vaccin à produire. Celui-ci lance l’analyse et, à l’aide d’un module RAG (permet à l’IA de disposer de données supplémentaires sans réentrainement), croise ces informations avec la base de données de l’entreprise. Enfin, l’assistant retourne aux employés un fichier d’instructions pour les machines qu’ils peuvent directement pour lancer une production.

Scénario d’attaque

Figure 5 – Kill chain scénario d’attaque sur assistant à la production de vaccins

Les suites d’un cas de vol de secrets industriels comme celui-ci peuvent-être la revente de ces informations à des concurrents, ou encore leur divulgation publique, pouvant entraîner d’importantes conséquences financières et sur la réputation de l’entreprise. Cependant, des mesures de sécurité classiques de gestion des accès permettent de réduire le risque de subir ce type d’attaque.

En outre, bien que certaines applications de l’IA soient vulnérables à de nouvelles attaques, des mesures de sécurité spécifiques et adaptées aux faiblesses de chaque système permettent de maintenir une protection efficace.

Alors que faut-il retenir ?

En fin de compte, les risques associés aux technologies d’IA ne sont pas fondamentalement nouveaux.

Bien que certains systèmes d’IA soient sensibles à de nouvelles attaques, les principes de cybersécurité permettant de s’en protéger et de limiter les impacts restent inchangés.

Il reste donc essentiel d’adopter une approche par les risques et d’intégrer la sécurité dès la conception de toute application d’IA (cybersecurity by design).