Parmi les technologies qui paraissaient être de la science-fiction il y a quelques décennies, et qui font aujourd’hui partie intégrante de l’écosystème numérique, la Reconnaissance Faciale (RF) occupe une place de choix. Cet outil se retrouve en effet de plus en plus dans notre quotidien : déverrouillage de nos téléphones, portiques douaniers dans les aéroports, authentification pour systèmes de paiement, tri automatisé de nos photos ou encore recherche de personnes.

Démystification du fonctionnement

Ces technologies ont comme objectifs d’identifier et d’extraire les visages d’images ou de flux vidéo, et de calculer une empreinte faciale pour chacun de ces visages, encapsulant l’ensemble de leurs caractéristiques, afin de faciliter une recherche et identification par la suite.

L’idée d’utiliser le visage comme information d’identification dans des systèmes ainsi que les premiers systèmes fonctionnels remonte aux débuts des années 1960 avec le système Woodrow Wilson Bledsoe (1964), le système était capable de reconnaître des visages en analysant des photos numérisées. Son approche reposait sur l’identification des caractéristiques faciales telles que la distance entre les yeux et la largeur du nez.

Les dernières avancées en matière d’intelligence artificielle, notamment avec l’avènement du Machine Learning ainsi que l’explosion du volume de photos et vidéos partagé sur Internet, ont permis un développement rapide et massif des algorithmes de reconnaissance faciale.

En pratique, ces systèmes s’appuieront sur les images capturées par nos smartphones et caméra, constituées d’une grille de pixels, portant chacun les valeurs des trois couleurs, rouge, vert et bleu pour le pixel en question. Contrairement au fonctionnement de la vision humaine, c’est sous cette forme complètement numérique que le système de RF appréhendera les images. Le traitement qu’appliquera l’algorithme de RF devra ainsi généralement suivre les 5 étapes suivantes :

- Capture de l’image : Tout commence par la capture d’une image contenant un visage. Cette image peut provenir d’une photo prise par une caméra tout comme être extraite d’une vidéo.

- Détection du visage : L’algorithme va analyser l’image pour détecter la présence et la position des visages. Pour cela il va utiliser des techniques de traitement d’image pour rechercher des motifs et des schémas caractéristiques des visages, comme les contours, les éléments structurant (comme les yeux) et les variations de luminosité

- Extraction des caractéristiques faciales de la personne : Une fois le visage est détecté, l’algorithme extrait des caractéristiques spécifiques qui vont permettre de le distinguer des autres visages. Ces caractéristiques incluent des éléments intelligibles (position des yeux, forme globale …) ainsi que des éléments intelligibles uniquement par le modèle IA (dégradé et arrangements spécifiques de pixels)

- Création d’une empreinte faciale : A partir des caractéristiques extraites, l’algorithme crée une empreinte faciale, qui est essentiellement un résumé du visage, sur un format numérique compréhensible pour le modèle.

- Comparaison avec la base de données : Afin de réaliser des identifications et des recherches, l’empreinte faciale obtenue pourra être comparée avec des bases de données d’empreinte ou d’image. Les correspondances trouvées mentionneront généralement un pourcentage de confiance, selon le niveau de ressemblance calculé.

De nos jours, les mécaniques sous-jacentes de traitement d’image et de Machine Learning peuvent offrir des performances excellentes, en termes de rapidité ou de cohérence des résultats. Mais au même titre que le reste des services technologiques automatisés, elles peuvent souffrir de vulnérabilité de sécurité cyber, et peuvent dans certains cas être détournées par un attaquant.

Panorama des attaques et faiblesses

L’objectif ne sera pas d’énumérer l’ensemble des attaques potentielles sur les systèmes liés au Machine Learning, mais de se concentrer sur les attaques pouvant viser les algorithmes de RF. Les principales typologies sont les suivantes :

Les attaques par adversaire (Adversary Attacks)

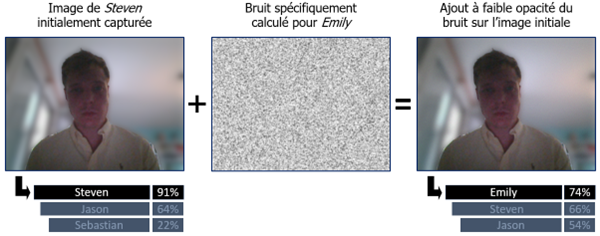

Premières fissures dans l’armure des algorithmes de RF, découvertes dans les années 2010, leur principe est d’introduire subtilement un bruit très léger dans les images envoyées au système. Cette altération, quasi invisible pour un être humain, bouleversera en revanche les caractéristiques fines vues par le modèle, et pourra permettre volontairement des erreurs de compréhension et de classification par le réseau de neurones sous-jacent. S’il est en mesure d’altérer les images envoyées, un attaquant ayant une bonne connaissance du système en question pourrait ainsi usurper l’identité d’un utilisateur.

Exemple d’attaque par adversaire

Attaques par occlusion

Dès 2015, des chercheurs ont pu mettre en pratique des attaques où l’occlusion de parties du visage, comme par le port de lunettes ou de masques, peut permettre de tromper certains modèles de RF. En effet, le modèle pourra ne pas réussir à détecter et extraire de visages des images capturées, ou bien à extraire des caractéristiques incohérentes. Dans les deux cas, de telles attaques permettent une anonymisation des sujets

Exemples de dispositifs d’occlusion

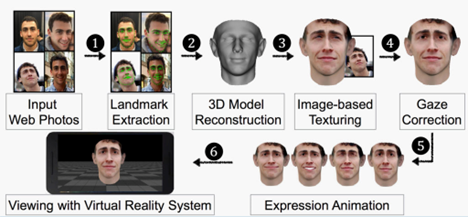

Attaques par substitution de visage

A l’instar des films d’espionnage, les chercheurs ont exploré les attaques par substitution de visage, utilisant des techniques parfois sophistiquées pour tromper les systèmes en présentant des visages artificiels qui ressemblent à de vrais visages. Les techniques peuvent aller du simple masque en carton, jusqu’à la reproduction d’un visage et de ses détails sur un masque « sur-mesure » en silicone. Ces attaques ont soulevé des préoccupations quant à la fiabilité des systèmes de reconnaissance faciale dans des scénarios du monde réel.

A noter que certains systèmes de RF (comme Windows Hello de Microsoft) s’appuieront sur une caméra infrarouge, pour notamment s’assurer d’être face à un vrai visage.

Procédure de création de visage pour une attaque par substitution de visage

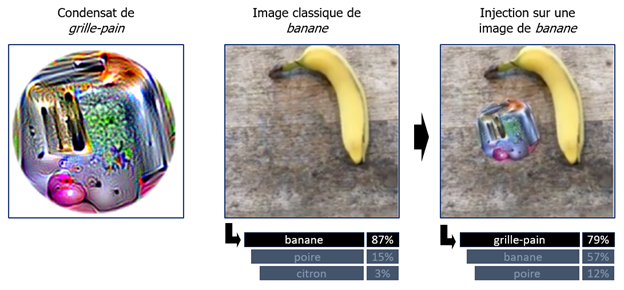

Attaques par superposition

Dans certains cas, une simple superposition d’un “patch” sur une autre image peut induire en erreur les algorithmes de RF. Il est possible de calculer l’image qui représente le mieux une personne ou un objet (un grille-pain dans notre cas) du point de vue du modèle, et d’insérer cet élément dans l’image que l’on souhaite détourner. Le modèle de RF aura tendance à se focaliser sur cette zone, et cela pourra altérer complètement ses prédictions.

Exemple d’attaque par superposition

Attaques par illumination

En jouant sur l’éclairage environnant, il est courant de pouvoir altérer la performance d’un algorithme de RF, mettant en avant la nécessité de prendre en compte les conditions environnementales.

Demain, une défense à la hauteur des risques

Face à ces systèmes faillibles, tout un ensemble de stratégies de protection apparaissent, misant généralement sur la vérification de la cohérence et la véracité des images présentées. Un bref panorama des axes de travail pour la défense :

- Clignement des yeux : Le clignement des yeux peut être utilisé comme mécanisme de défense pour vérifier l’authenticité des visages en temps réel, en effet le clignement des yeux est dur à reproduire et manière naturelle sur une image ou une vidéo. En se basant sur des schémas de clignement naturels, les systèmes de reconnaissance faciale peuvent détecter les tentatives de fraude et renforcer la sécurité de l’identification biométrique.

- Analyse de la démarche : L’analyse de la démarche offre une couche supplémentaire de défense en vérifiant la cohérence entre l’identité revendiquée et la manière dont une personne marche. Cette méthode peut aider à prévenir les attaques basées sur des imposteurs ou des contrefaçons en détectant les irrégularités dans la manière dont une personne se déplace, renforçant ainsi la sécurité des systèmes de reconnaissance faciale.

- Analyse de la vivacité des visages : En utilisant des caractéristiques dynamiques du visage, tels que les mouvements musculaires et les clignements des yeux, l’analyse de la vivacité des visages permet de distinguer les visages réels des faux, empêchant ainsi les attaques basées sur des images ou des vidéos préenregistrées. Cette technique renforce la sécurité de l’authentification biométrique en s’assurant que les visages soumis à la reconnaissance sont vivants et en direct.

- Scan 3D complet : Le scan 3D complet capture les détails tridimensionnels du visage, offrant une représentation plus précise et difficile à contrefaire. En utilisant cette technique, les systèmes de reconnaissance faciale peuvent détecter les tentatives de fraude par des masques ou des sculptures faciales, renforçant ainsi la sécurité de l’identification biométrique.

- Techniques biométriques complémentaires de confiance : En combinant plusieurs modalités biométriques telles que la reconnaissance faciale, l’empreinte digitale et la reconnaissance de la voix, les systèmes de reconnaissance faciale peuvent bénéficier de multiples niveaux de défense. Cette approche renforce la sécurité en réduisant les risques d’erreurs de reconnaissance et de contournement, offrant ainsi une identification biométrique plus robuste et fiable.

Conclusion

De par leur conception en “boite noire”, les systèmes basés sur l’IA, avec plus récemment l’IA générative, sont actuellement faillibles. De nouvelles typologies et techniques d’attaque voient le jour, au même titre que des technologies de défense.

Dans le cas de la reconnaissance faciale, elle peut exposer ses utilisateurs à des risques évidents d’usurpation d’identité, avec de plus une perméabilité pro/perso, comme toute authentification biométrique, à la différence d’un simple mot de passe.

Avec la démocratisation des technologies de “deepfake”, et l’érosion de notre confiance dans les images, un effort de sécurisation de ces systèmes doit être assuré, à la hauteur de la grande responsabilité pouvant leur être accordée.